Como defender seu site de ataques

Boa parte do tráfego da internet hoje é feita por robôs. Há robôs com bons propósitos como o de indexar as páginas da internet e permitir que você as localize nos mecanismos de busca. São chamados de crawlers e entre eles estão os robôs dos principais mecanismos de busca: o Google Bot, o Bing Bot da Microsoft entre outros.

No entanto há robôs em operação buscando por vulnerabilidades nos sites e a estes você deve ficar atento.

A segurança da informação deve ser tratada como um processo contínuo, de conhecimento do cenário e de revisões constantes. É um bom hábito manter-se informado sobre as novidades envolvendo as tecnologias utilizadas nos seus sites, conhecendo seus nomes e versões e tomando conhecimento de vulnerabilidades divulgadas em sites especializados e fóruns.

Algumas tecnologias novas de programação são baseadas em sincronização facilitada de dependências, ou seja, bibliotecas de terceiros são mencionadas no código e com um conjunto breve de comandos a atualização é feita pela internet. É um grande recurso de produtividade pois permite que as bibliotecas evoluam de forma independente e que você mantenha seu foco nas funções específicas do seu site, apenas mantendo as dependências sincronizadas.

Um problema trazido por esta filosofia relativamente nova de programação é que você traz para o contexto da sua aplicação códigos cujas alterações você não acompanha de perto. Este código por vezes está na árvore do seu site em caminhos padronizados e conhecidos. Este é o caso de aplicações e websites desenvolvidos com Wordpress ou com Symphony – framework utilizado com PHP.

Se alguma das dependências utilizadas tiver uma fragilidade, seu site estará exposto. Se o seu conteúdo é público a preocupação não será tão grande quanto para um site de conteúdo restrito e credenciais de acesso. O risco é o que se tem visto na imprensa como vazamento de dados.

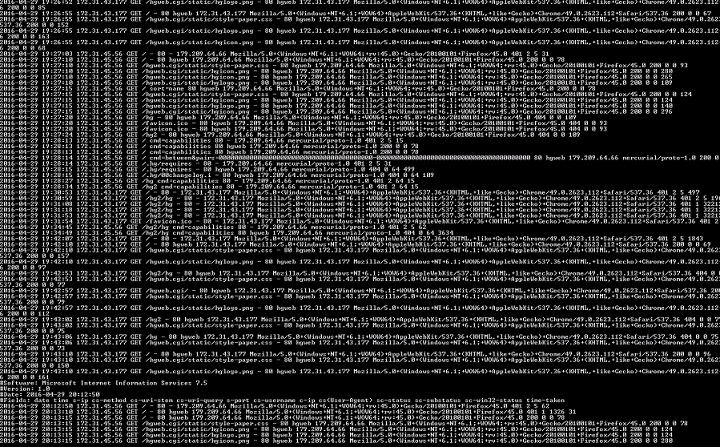

O nosso conselho principal para a prevenção é: saiba o que está acontecendo. Se você utiliza um serviço de publicação de sites, procure conhecer os recursos que o painel do serviço proporciona, principalmente relacionado aos logs de páginas servidas. Para os que utilizam servidores na nuvem, e que têm acesso ao sistema operacional, as possibilidades de verificações são mais amplas.

Procure identificar nos logs tentativas de acesso a páginas usando parâmetros que normalmente sua aplicação não produziria. Atente também para solicitações de páginas não encontradas, que comumente produzem o erro HTTP 404. Quando robôs fazem varreduras – ou scan – buscando por fragilidades, buscam por uma série de nomes e caminhos padrões de página que produzirão erros deste tipo quando não encontrados no seu site.

Se você identificar algo que realmente oferece risco para o seu site é hora de partir para a ação.

Algumas sugestões para apurar são: